什么是网络爬虫?

网络爬虫又称网页蜘蛛,网络机器人,是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。如果有兴趣可查看百度百科网络爬虫

网络蜘蛛(web spider)也叫网络爬虫,是一种’自动化浏览网络’的程序,或者说是一种网络机器人,它们被广泛用于互联网搜索引擎或其他类似网站,以获取或者更新这些网站的内容和检索方式,它们可以自动采集所有能够访问到的页面内容,以供搜索引擎做进一步处理(分检整理下载的页面),而使得用户能更快的检索到他们需要的信息

Scrapy使用Twisted这个异步网络库来处理网络通讯,架构清晰,并且包含了各种中间件接口,可以灵活的完成各种需求。

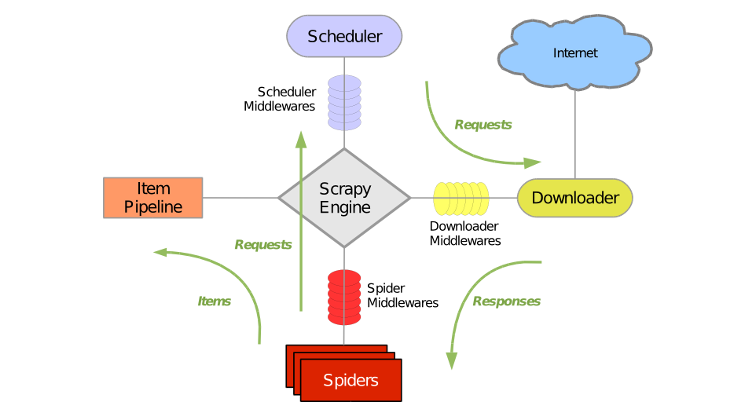

整体架构

引擎(Scrapy Engine),用来处理整个系统的数据流处理,触发事务。

调度器(Scheduler),用来接受引擎发过来的请求,压入队列中,并在引擎再次请求的时候返回。

下载器(Downloader),用于下载网页内容,并将网页内容返回给蜘蛛。

蜘蛛(Spiders),蜘蛛是主要干活的,用它来制定特定域名或者网页的解析规则,编写用于分析response并提取item(需要获取的内容item)或需要额外跟进的URL的类,每个spider负责处理一个特定(或一些)网站。

项目管道(item pipline),负责处理有蜘蛛从网页中提取的项目,它的主要任务是清晰,验证和存储数据,当页面被蜘蛛解析后,将被发送到项目管道,并经过几个特定的次序处理数据。

下载器中间件(Downloader Middlewares),位于Scrapy引擎和下载器之间的钩子框架,主要是处理Scrapy引擎与下载器之间的请求及响应。

蜘蛛中间件(Spider Middlewares),介于Scrapy引擎和蜘蛛之间的钩子框架,主要工作是处理蜘蛛的响应输入和请求输出。

调度中间件(Scheduler Middlewares),介于Scrapy引擎和调度之间的中间件,从Scrapy引起发送到调度的请求和响应。

爬取流程

先从起始URL开始,调度程序会将其交给Downloader进行下载,下载之后会交给Spider进行分析,Spider分析出来的结果有两种:一种是需要跟进抓取的链接,例如之前分析的”下一页”的链接,这些东西会被传回给调度程序;另一种是需要保存的数据,它们则被送到Item Pipeline那里,那是对数据进行后期处理(详细分析,分析,过滤,存储等)的地方,另外,在数据流动的通道里还可以安装各种中间件,进行必要的处理。

数据流

Scrapy中的数据流由执行引擎控制,其过程如下:

- 引擎打开一个网站,找到处理该网站的Spider并向该spider请求第一个要爬取的URL

- 引擎从Spider中获取到第一个要爬取的URL并在调度器(Scheduler)以Request调度

- 引擎向调度器请求下一个要爬取的URL

- 调度器返回下一个要爬取的URL给引擎,引擎将URL通过下载中间件(请求(request)方向)转发给下载器(Downloader)

- 一旦页面下载完毕,下载器生成一个该页面的Response,并将其通过下载中间件(返回response)发给引擎

- 引擎从下载器中接收到Response并通过Sipder中间件(输入方向)发送给Spider处理

- Spider处理Response并返回爬取到的Item及(跟进的)新的Request给引擎

- 引擎将(Spider返回的)爬取到的Item给 Item Pipline,将Spider返回的Request给调度器

- (从第二步)重复直到调度器中没有request(请求),引擎关闭该网站

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试