文章目录

0 前言

🔥 Hi,大家好,这里是丹成学长的毕设系列文章!

🔥 对毕设有任何疑问都可以问学长哦!

这两年开始,各个学校对毕设的要求越来越高,难度也越来越大… 毕业设计耗费时间,耗费精力,甚至有些题目即使是专业的老师或者硕士生也需要很长时间,所以一旦发现问题,一定要提前准备,避免到后面措手不及,草草了事。

为了大家能够顺利以及最少的精力通过毕设,学长分享优质毕业设计项目,今天分享一个教程

🚩 基于python的爬虫实现

1 简介

爬虫常用与毕业设计的数据收集阶段, 多同学要求和反应, 让学长出一片讲解爬虫的文章.

本文将描述和解析爬虫怎么使用, 并且给出实例.

所谓爬虫就是编写代码从网页上爬取自己想要的数据,代码的质量决定了你能否精确的爬取想要得到的数据,得到数据后能否直观正确的分析。

Python无疑是所有语言中最适合爬虫的。Python本身很简单,可是真正用好它需要学习大量的第三方库插件。比如matplotlib库,是一个仿照matalab的强大的绘图库,用它可以将爬下来的数据画出饼图、折线图、散点图等等,甚至是3D图来直观的展示。

Python第三方库的安装可以手动安装,但是更为简便的是在命令行直接输入一行代码即可自动搜索资源并安装。而且非常智能,可以识别自己电脑的类型找到最合适的版本。

Pip install +你所需要的第三方库

或者是easy install +你所需要的第三方库

这里建议大家使用pip安装,因为pip可以安装也可以卸载,而另一种方法只能安装。如果遇到你想使用新的版本的第三方库,使用pip的优势就会显现出来。

🧿 选题指导, 项目分享:

https://blog.csdn.net/Mr_DC_IT/article/details/126460477

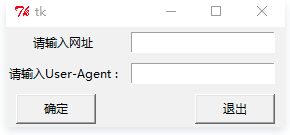

2 交互界面

def web(): root = Tk() Label(root,text='请输入网址').grid(row=0,column=0) #对Label内容进行表格式布局 Label(root,text='请输入User-Agent :').grid(row=1,column=0) v1=StringVar() #设置变量 v2=StringVar() e1 = Entry(root,textvariable=v1) #用于储存 输入的内容 e2 = Entry(root,textvariable=v2) e1.grid(row=0,column=1,padx=10,pady=5) #进行表格式布局 e2.grid (row=1,column=1,padx=10,pady=5) url = e1.get() #将从输入框中得到的网址赋值给url head = e2.get()

3 爬虫部分

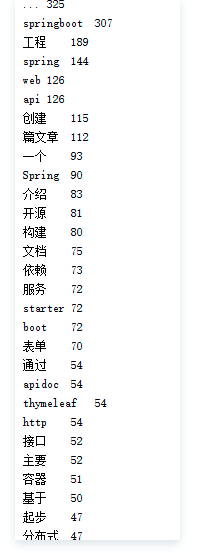

使用爬虫爬取随便一个博客,并对其所有的文章进行结巴分词。从而提取关键词,分析这位博主使用当下比较热的与互联网相关的词汇的频率。

先编写一个函数download()获取url,接着编写一个函数parse_descrtion()解析从

url中获取的html,最后结巴分词。

def download(url): #通过给定的url爬出数据 if url is None: return None try: response = requests.get(url, headers={'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_11_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/53.0.2785.143 Safari/537.36', }) if (response.status_code == 200): return response.content return None except: return None

def parse_descrtion(html): if html is None: return None soup = BeautifulSoup(html, "html.parser") #html字符串创建BeautifulSoup links = soup.find_all('a', href=re.compile(r'/forezp/article/details')) for link in links: titles.add(link.get_text())

def jiebaSet(): strs='' if titles.__len__()==0: return for item in titles: strs=strs+item; tags = jieba.analyse.extract_tags(strs, topK=100, withWeight=True) for item in tags: print(item[0] + '\t' + str(int(item[1] * 1000)))

第一个函数没什么好说的。

第二个函数用到了beautifulsoup,通过对网页的分析,从而寻找所有的满足条件为

href=re.compile(r’/forezp/article/details’)的a标签里的内容。

第三个函数就是结巴分词。接下来对结巴分词作简单的介绍。

支持三种分词模式。

精确模式:试图将句子最精确地切开,适合文本分析。

全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义。

搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

举个例子,结巴分词“我来到北京清华大学”这句话。

【全模式】:我/来到/北京/清华/清华大学/华大/大学

【精确模式】:我/来到/北京/清华大学

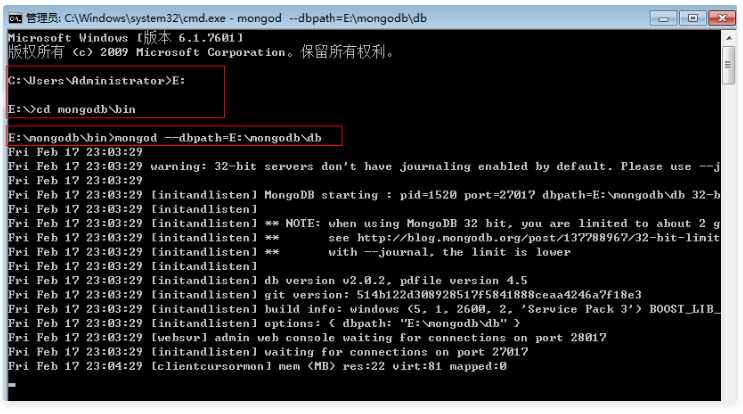

4 数据存储

我这里使用mongoDB数据库, 同学们可以选取自己熟悉或符合要求的数据库

client = pymongo.MongoClient(“localhost”, 27017)

这句是使用给定主机位置和端口。pymongo的Connection()方法不建议使用,官方推荐新方法MongoClient()。

db = client[‘local’]

这句是将创建好mongoDB后默认存在的两个数据库中的其中一个“local”赋给db,这样

db在以后的程序里就代表数据库local。

posts = db.pymongo_test

post_id = posts.insert(data)

将local里默认的一个集合“pymongo_test”赋值给posts,并且用insert方法单个插入数据。最后回到结巴分词里的一个循环程序里,将数据依次插入。

以上是有关连接数据库的核心代码,接下来介绍如何启动mongoDB数据库。(我一开始编程怎么都连接不上,后来发现是数据库自身没有启动,唉,编程里发生的傻逼事情实在是太多了。)

微软徽标+R,输入cmd,找“mongodb”的路径,然后运行mongod开启命令,同时用–dbpath指定数据存放地点为“db”文件夹。

启动mongoDB

我这里是放在了E盘,大家根据需要自己设置。最后要看下是否开启成功,从图中的信息中获知,mongodb采用27017端口,那么我们就在浏览器输http://localhost:27017,打开后mongodb告诉我们在27017上Add 1000可以用http模式查看mongodb的管理信息。

🧿 选题指导, 项目分享:

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试