爬虫入门—网页信息爬取

一、网络爬虫简介

1.概念

网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有ipipgo、自动索引、模拟程序或者蠕虫。

2.类型

网络爬虫按照系统结构和实现技术,大致可以分为以下几种类型:通用网络爬虫(General Purpose Web Crawler)、聚焦网络爬虫(Focused Web Crawler)、增量式网络爬虫(Incremental Web Crawler)、深层网络爬虫(Deep Web Crawler)。 实际的网络爬虫系统通常是几种爬虫技术相结合实现的。

3.使用范围

- 作为搜索引擎的网页搜集器,抓取整个互联网,如谷歌,百度等。

- 作为垂直搜索引擎,抓取特定主题信息,如视频网站,招聘网站等。

- 作为测试网站前端的检测工具,用来评价网站前端代码的健壮性。

4.合法性

Robots协议:又称机器人协议或爬虫协议,该协议就搜索引擎抓取网站内容的范围作了约定,包括网站是否希望被搜索引擎抓取,哪些内容不允许被抓取,网络爬虫据此“自觉地”抓取或者不抓取该网页内容。自推出以来Robots协议已成为网站保护自有敏感数据和网民隐私的国际惯例。

5.搜索策略

网页的抓取策略可以分为深度优先、广度优先和最佳优先三种。深度优先在很多情况下会导致爬虫的陷入(trapped)问题,目前常见的是广度优先和最佳优先方法。

6.基本结构

- URL管理模块

- 下载模块

- 解析模块

- 存储模块

二、环境准备

Anaconda的安装与配置:

史上最详细的Anaconda安装教程

需要安装的包:

requests、beautifulsoup4、html5lib

指令如下:

pip install beautifulsoup4

pip install requests

pip install html5lib

三、爬取南阳理工学院ACM题目网站

南阳理工学院ACM题目网站

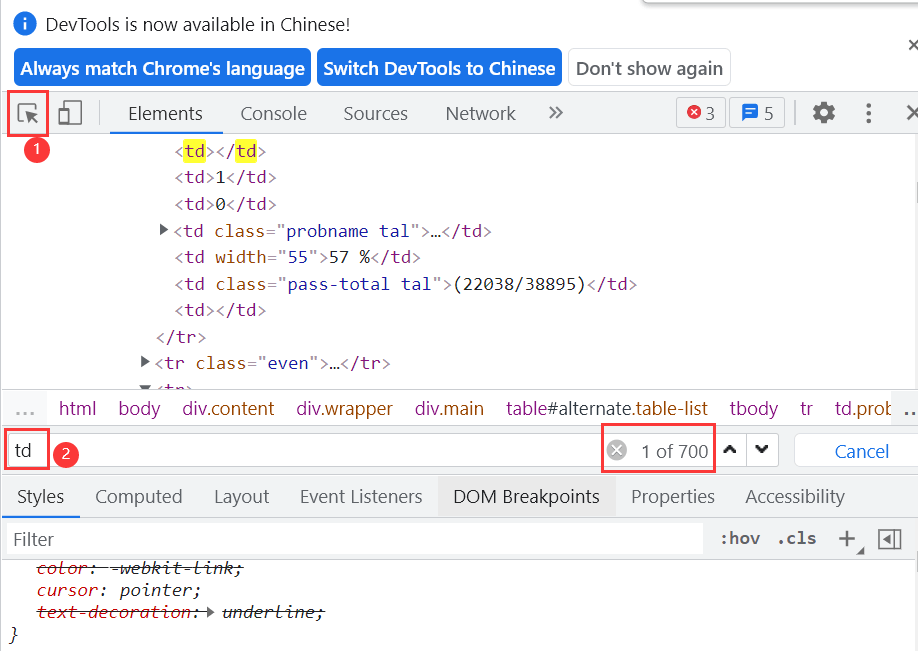

通过查看网页源代码可知,我们所需要的题号、标题、通过率等数据都在图TD标签内

在网站页面按F12进入开发者模式,搜索框内输入td显示有700多条相关数据

在自己需要的位置创建一个.csv文件

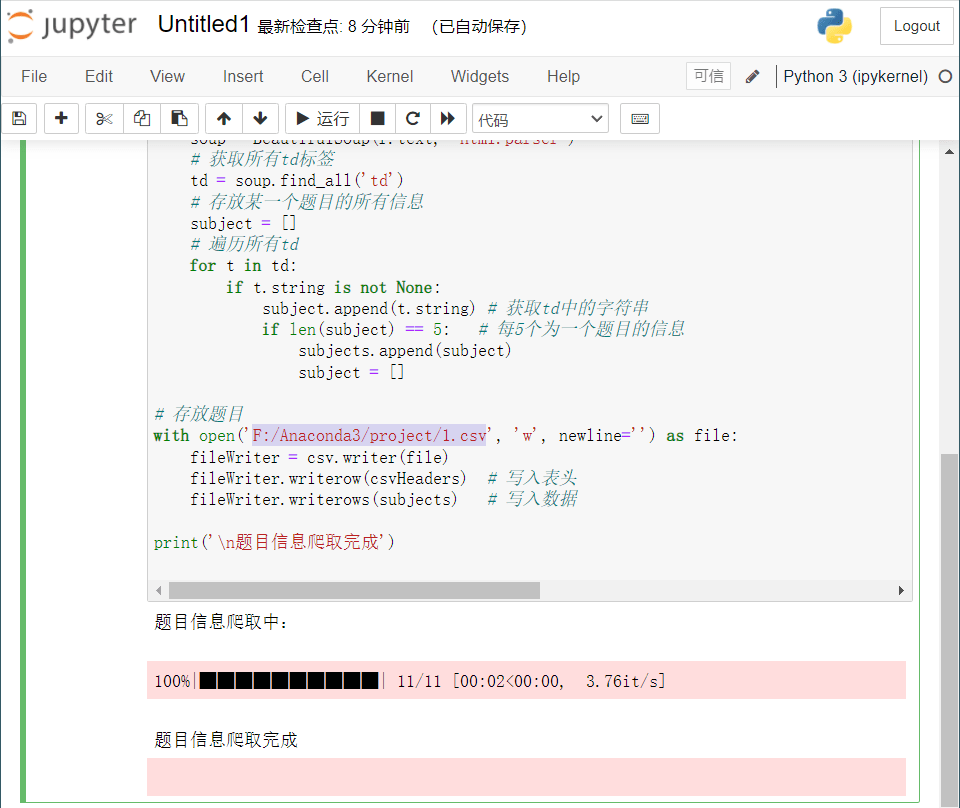

打开anaconda中的jupyter notebook进行编码

import requests from bs4 import BeautifulSoup import csv from tqdm import tqdm

# 模拟浏览器访问 Headers = 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400'

# 表头 csvHeaders = ['题号', '难度', '标题', '通过率', '通过数/总提交数']

# 题目数据 subjects = []

# 爬取题目 print('题目信息爬取中:\n') # tqdm作业:以进度条方式显示爬取进度 # 爬取11页所有题目信息 for pages in tqdm(range(1, 11 + 1)): # get请求第pages页 r = requests.get(f'http://www.51mxd.cn/problemset.php-page={pages}.htm', Headers) # 判断异常 r.raise_for_status() # 设置编码 r.encoding = 'utf-8' # 创建BeautifulSoup对象,用于解析该html页面数据 soup = BeautifulSoup(r.text, 'html.parser') # 获取所有td标签 td = soup.find_all('td') # 存放某一个题目的所有信息 subject = [] # 遍历所有td for t in td: if t.string is not None: subject.append(t.string) # 获取td中的字符串 if len(subject) == 5: # 每5个为一个题目的信息 subjects.append(subject) subject = []

# 存放题目 with open('F:/Anaconda3/project/1.csv(这是我的.csv文件路径)', 'w', newline='') as file: fileWriter = csv.writer(file) fileWriter.writerow(csvHeaders) # 写入表头 fileWriter.writerows(subjects) # 写入数据

print('\n题目信息爬取完成!!!')

运行结果如下:

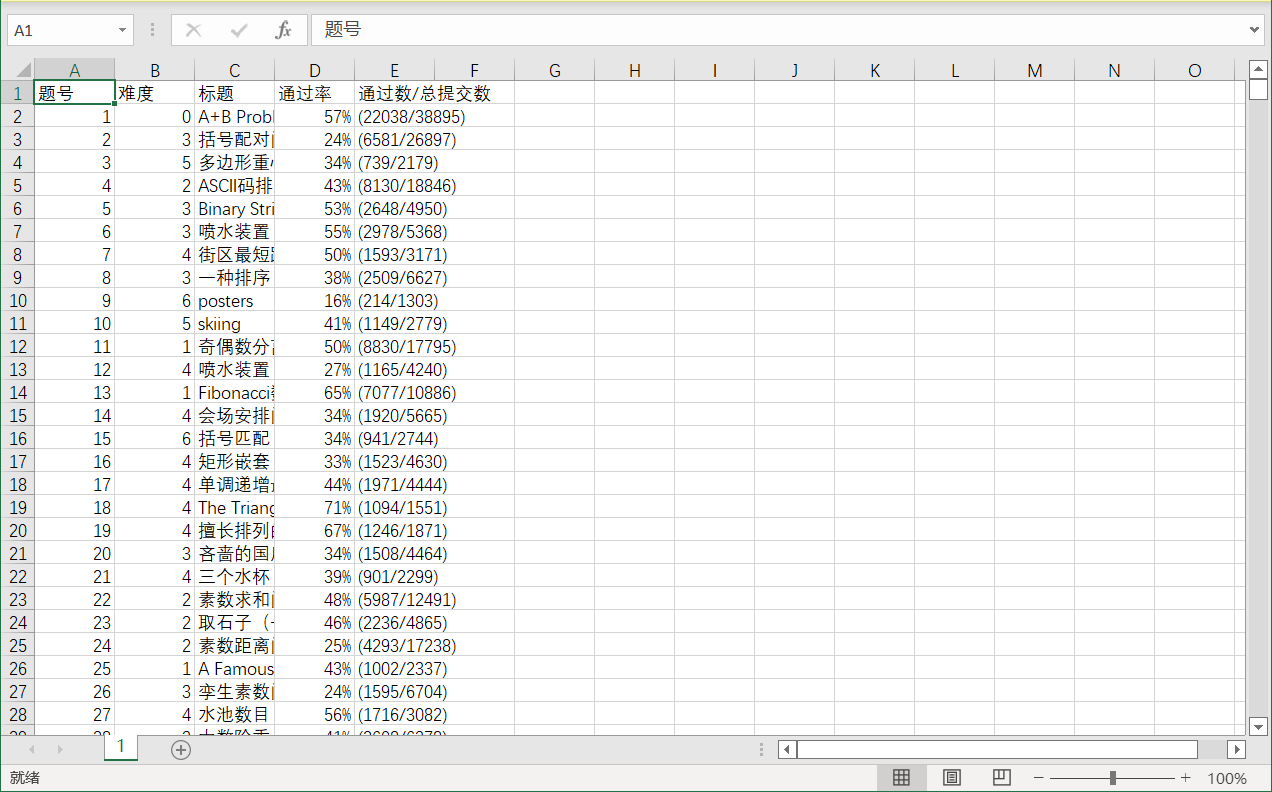

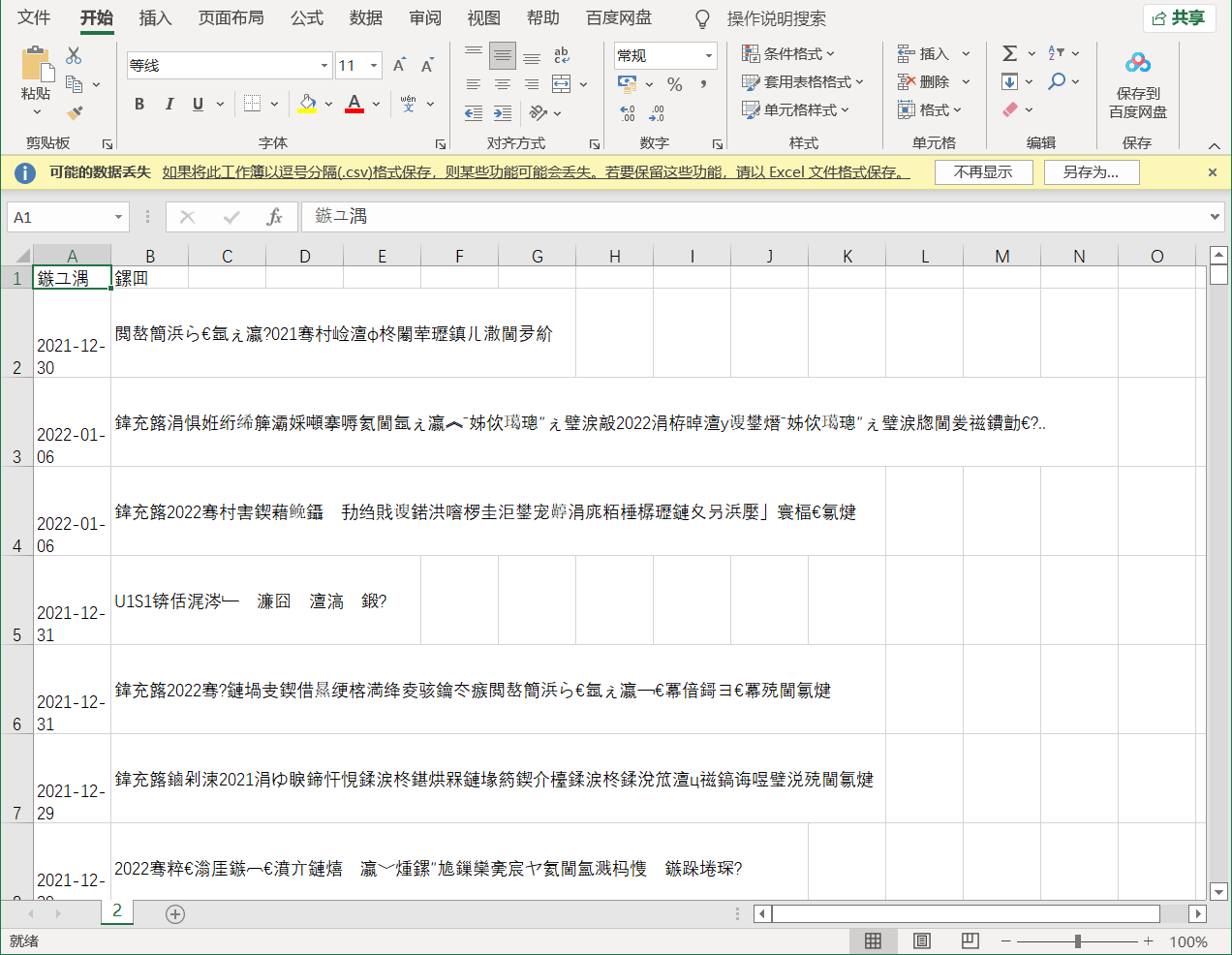

查看.csv文件内容:

四、爬取重庆交通大学新闻网站

重庆交通大学新闻网

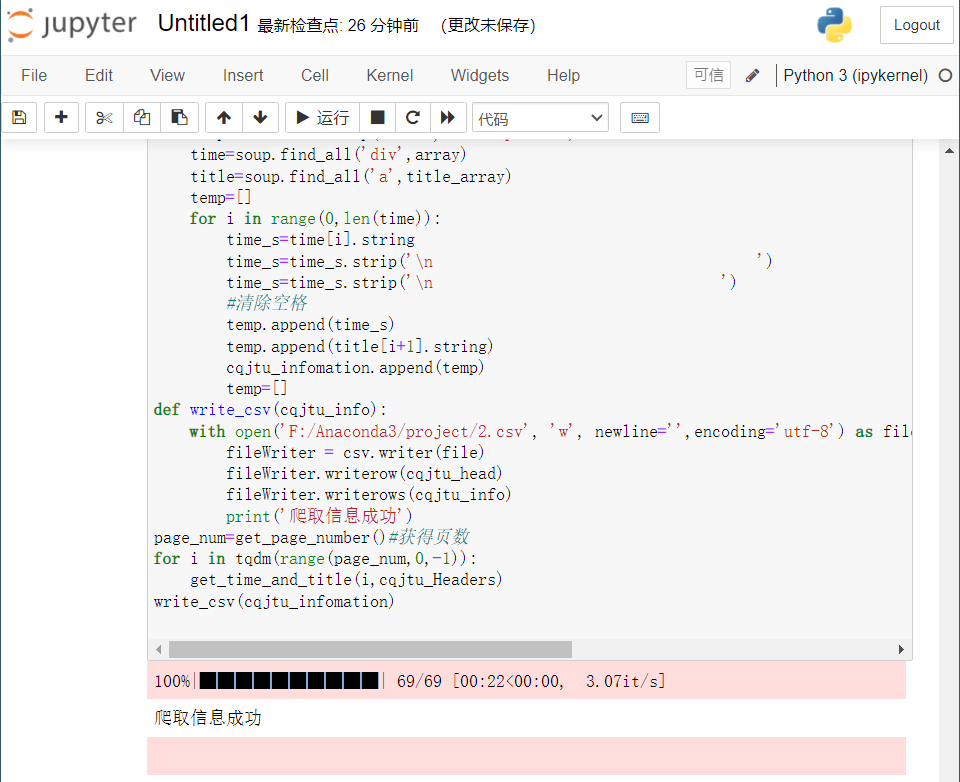

编码如下:

import requests from bs4 import BeautifulSoup import csv from tqdm import tqdm

# 模拟浏览器访问 cqjtu_Headers ={ 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36 Edg/95.0.1020.44' } #csv的表头 cqjtu_head=["日期","标题"] #存放内容 cqjtu_infomation=[] def get_page_number(): r=requests.get(f"http://news.cqjtu.edu.cn/xxtz.htm",headers=cqjtu_Headers) r.raise_for_status() r.encoding="utf-8" page_array={ 'type':'text/javascript' } soup = BeautifulSoup(r.text, 'html5lib') page_num=soup.find_all('script',page_array) page_number=page_num[4].string#只靠标签这些定位好像不是唯一,只能手动定位了 page_number=page_number.strip('function a204111_gopage_fun(){_simple_list_gotopage_fun(')#删掉除页数以外的其他内容 page_number=page_number.strip(',\'a204111GOPAGE\',2)}') page_number=int(page_number)#转为数字 return page_number def get_time_and_title(page_num,cqjtu_Headers):#页数,请求头 if page_num==69 : url='http://news.cqjtu.edu.cn/xxtz.htm' else : url=f'http://news.cqjtu.edu.cn/xxtz/{page_num}.htm' r=requests.get(url,headers=cqjtu_Headers) r.raise_for_status() r.encoding="utf-8" array={#根据class来选择 'class':'time', } title_array={ 'target':'_blank' } page_array={ 'type':'text/javascript' } soup = BeautifulSoup(r.text, 'html.parser') time=soup.find_all('div',array) title=soup.find_all('a',title_array) temp=[] for i in range(0,len(time)): time_s=time[i].string time_s=time_s.strip('\n ') time_s=time_s.strip('\n ') #清除空格 temp.append(time_s) temp.append(title[i+1].string) cqjtu_infomation.append(temp) temp=[] def write_csv(cqjtu_info): with open('F:/Anaconda3/project/2.csv', 'w', newline='',encoding='utf-8') as file: fileWriter = csv.writer(file) fileWriter.writerow(cqjtu_head) fileWriter.writerows(cqjtu_info) print('爬取信息成功') page_num=get_page_number()#获得页数 for i in tqdm(range(page_num,0,–1)): get_time_and_title(i,cqjtu_Headers) write_csv(cqjtu_infomation)

运行结果:

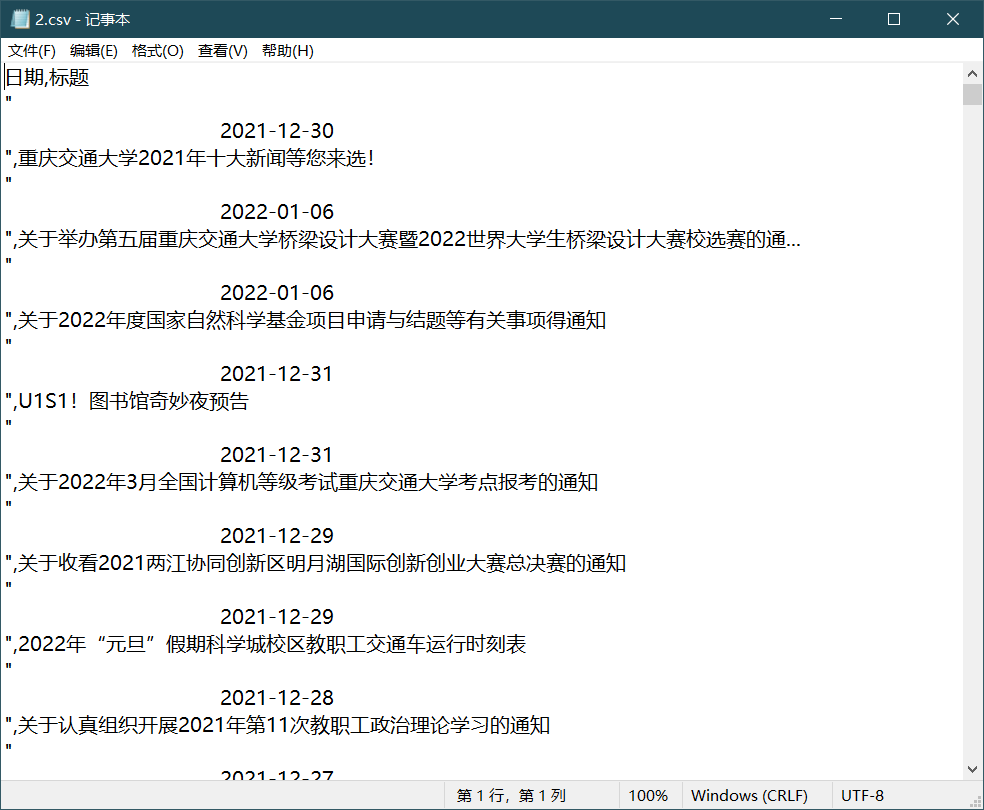

查看.csv文件

消息显示为乱码,可能是字符集的问题,换用记事本打开

信息爬取成功

参考

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试